Evento

13 de Junio de 2025

AMD presentó su visión integral para la IA abierta en su evento Advancing AI 2025

La industria está "entrando en la próxima fase de la IA, impulsada por estándares abiertos, innovación compartida y el liderazgo cada vez mayor de AMD".

AMD ha consolidado su posición como un actor clave en el panorama de la inteligencia artificial, revelando una plataforma de IA integrada y una infraestructura abierta y escalable en su evento anual Advancing AI 2025. La compañía destacó su enfoque único que abarca GPUs, CPUs, redes y software abierto para ofrecer flexibilidad y rendimiento.

La Dra. Lisa Su, presidenta y CEO de AMD, enfatizó que "AMD está impulsando la innovación en IA a un ritmo sin precedentes" y que la industria está "entrando en la próxima fase de la IA, impulsada por estándares abiertos, innovación compartida y el liderazgo cada vez mayor de AMD".

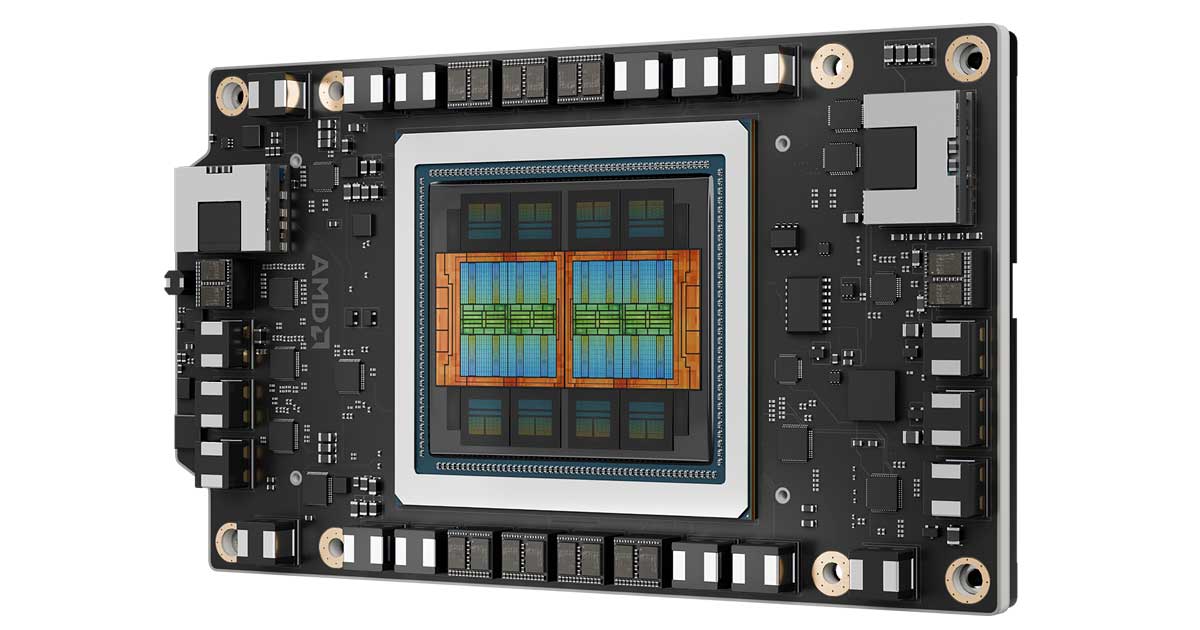

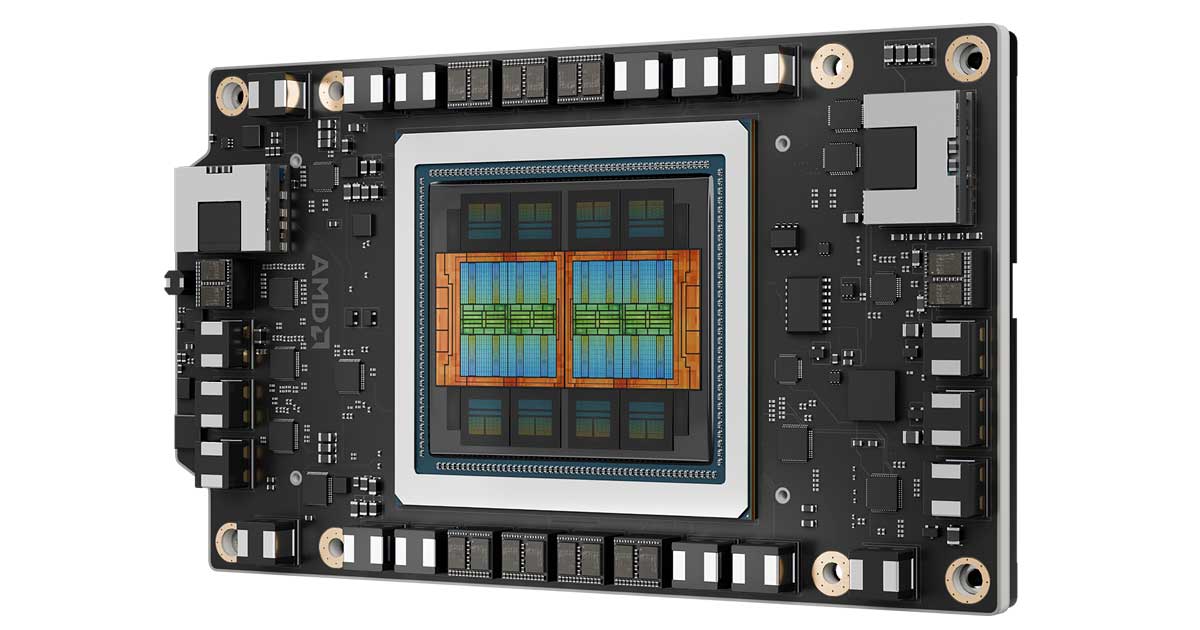

En el centro de los anuncios se encuentran los nuevos GPUs AMD Instinct Serie MI350, que incluyen los modelos Instinct MI350X y MI355X, y prometen un aumento de 4 veces en la capacidad de cómputo de IA en comparación con la generación anterior y un salto generacional de 35 veces en inferencia. Además, el MI355X ofrece una mejora significativa en la relación costo-rendimiento, generando hasta un 40% más de tokens por dólar en comparación con soluciones competidoras.

La serie MI350 está construida sobre la arquitectura AMD CDNA 4 y ofrece una capacidad de memoria de 288 GB HBM3E y un ancho de banda de hasta 8 TB/s. Estos GPUs ya están siendo implementados en la infraestructura de IA de AMD a escala de rack, que también incluye procesadores AMD EPYC de 5ª generación y NICs AMD Pensando Pollara. Esta solución estará disponible en la segunda mitad de 2025 y ya ha sido adoptada por líderes de la industria.

AMD Instinct Serie MI350

Mirando hacia el futuro, AMD ofreció un adelanto de su próxima generación de racks de IA, denominada "Helios", que se espera para 2026. "Helios" estará construida con los GPUs AMD Instinct Serie MI400, proyectados para ofrecer hasta 10 veces más rendimiento en la ejecución de inferencias en modelos Mixture of Experts. Se espera que los GPUs MI400 cuenten con hasta 432 GB de memoria HBM4, un ancho de banda de memoria de 19.6 TB/s y 40 PFLOPS de rendimiento FP4.

Este sistema de próxima generación también incluirá los procesadores AMD EPYC "Venice" basados en la arquitectura "Zen 6", que se proyectan con hasta 256 núcleos y un ancho de banda de memoria de 1.6 TB/s, y las NICs AMD Pensando "Vulcano". "Helios" busca redefinir las capacidades a nivel de rack, ofreciendo una solución integrada y lista para implementar, diseñada para las cargas de trabajo de IA más exigentes.

El compromiso de AMD con un ecosistema abierto se refuerza con la última versión de su pila de software de IA de código abierto, ROCm 7. Diseñada para las crecientes demandas de la IA generativa y la computación de alto rendimiento, ROCm 7 mejora significativamente la experiencia del desarrollador. Esta versión ofrece un salto de rendimiento notable, con más de 3.5 veces la capacidad de inferencia y 3 veces la potencia de entrenamiento en comparación con la versión anterior de ROCm 6.

ROCm 7 incluye soporte mejorado para marcos estándar de la industria (como SGLang y vLLM), compatibilidad ampliada con hardware (incluyendo soporte para Radeon y Windows en portátiles y estaciones de trabajo) y nuevas herramientas de desarrollo, controladores, APIs y bibliotecas. Anush Elangovan, vicepresidente corporativo de Desarrollo de Software de IA en AMD, destacó que ROCm "está liderando la revolución de la IA abierta".

Para democratizar el acceso a sus capacidades de IA, AMD anunció la amplia disponibilidad de AMD Developer Cloud. Esta plataforma, diseñada para un desarrollo rápido y de alto rendimiento en IA, ofrece a los usuarios acceso a un entorno en la nube completamente gestionado con GPUs AMD Instinct MI300X, sin necesidad de inversión en hardware o configuración local. Incluye contenedores Docker preinstalados, opciones de cómputo escalables (desde 1x MI300X hasta 8x MI300X) y créditos complementarios para desarrolladores.

Nuevos aceleradores AMD Instinct Serie MI350

En el centro de los anuncios se encuentran los nuevos GPUs AMD Instinct Serie MI350, que incluyen los modelos Instinct MI350X y MI355X, y prometen un aumento de 4 veces en la capacidad de cómputo de IA en comparación con la generación anterior y un salto generacional de 35 veces en inferencia. Además, el MI355X ofrece una mejora significativa en la relación costo-rendimiento, generando hasta un 40% más de tokens por dólar en comparación con soluciones competidoras.

La serie MI350 está construida sobre la arquitectura AMD CDNA 4 y ofrece una capacidad de memoria de 288 GB HBM3E y un ancho de banda de hasta 8 TB/s. Estos GPUs ya están siendo implementados en la infraestructura de IA de AMD a escala de rack, que también incluye procesadores AMD EPYC de 5ª generación y NICs AMD Pensando Pollara. Esta solución estará disponible en la segunda mitad de 2025 y ya ha sido adoptada por líderes de la industria.

AMD Instinct Serie MI350

"Helios" y la Serie MI400

Mirando hacia el futuro, AMD ofreció un adelanto de su próxima generación de racks de IA, denominada "Helios", que se espera para 2026. "Helios" estará construida con los GPUs AMD Instinct Serie MI400, proyectados para ofrecer hasta 10 veces más rendimiento en la ejecución de inferencias en modelos Mixture of Experts. Se espera que los GPUs MI400 cuenten con hasta 432 GB de memoria HBM4, un ancho de banda de memoria de 19.6 TB/s y 40 PFLOPS de rendimiento FP4.

Este sistema de próxima generación también incluirá los procesadores AMD EPYC "Venice" basados en la arquitectura "Zen 6", que se proyectan con hasta 256 núcleos y un ancho de banda de memoria de 1.6 TB/s, y las NICs AMD Pensando "Vulcano". "Helios" busca redefinir las capacidades a nivel de rack, ofreciendo una solución integrada y lista para implementar, diseñada para las cargas de trabajo de IA más exigentes.

ROCm 7: El motor de software abierto para la IA

El compromiso de AMD con un ecosistema abierto se refuerza con la última versión de su pila de software de IA de código abierto, ROCm 7. Diseñada para las crecientes demandas de la IA generativa y la computación de alto rendimiento, ROCm 7 mejora significativamente la experiencia del desarrollador. Esta versión ofrece un salto de rendimiento notable, con más de 3.5 veces la capacidad de inferencia y 3 veces la potencia de entrenamiento en comparación con la versión anterior de ROCm 6.

ROCm 7 incluye soporte mejorado para marcos estándar de la industria (como SGLang y vLLM), compatibilidad ampliada con hardware (incluyendo soporte para Radeon y Windows en portátiles y estaciones de trabajo) y nuevas herramientas de desarrollo, controladores, APIs y bibliotecas. Anush Elangovan, vicepresidente corporativo de Desarrollo de Software de IA en AMD, destacó que ROCm "está liderando la revolución de la IA abierta".

Para democratizar el acceso a sus capacidades de IA, AMD anunció la amplia disponibilidad de AMD Developer Cloud. Esta plataforma, diseñada para un desarrollo rápido y de alto rendimiento en IA, ofrece a los usuarios acceso a un entorno en la nube completamente gestionado con GPUs AMD Instinct MI300X, sin necesidad de inversión en hardware o configuración local. Incluye contenedores Docker preinstalados, opciones de cómputo escalables (desde 1x MI300X hasta 8x MI300X) y créditos complementarios para desarrolladores.

- Otras Noticias

Malabia 1720 11b (Areatres) C1414DMJ

Capital Federal - Buenos Aires - Argentina

TE / FAX: (54-11) 5199-6274

© CanalLA | Publicidad

Desarrollado por: Tekmerion

América Latina

América Latina Argentina

Argentina Chile

Chile Colombia

Colombia México

México Uruguay

Uruguay